Doit-on avoir une approche scientifique ?

“L‘univers tout entier est un cocktail d‘ordre, de désordre, et d‘organisation. Nous sommes tous dans un univers d‘où l‘on ne peut écarter l‘aléa, l‘incertain, le désordre. Nous devons vivre et traiter avec le désordre“. Edgar Morin.

Je considère que la plupart du temps, la solution se trouve dans la nuance. Par rapport à ce qu’on peut lire ci et là, j’entends : sur le terrain, je déteste vouloir faire rentrer des carrés dans des ronds, et j’aime les choses simples que l’on peut mettre en place sans pinailler.

Si vous souhaitez allez plus loin, j'aborde ces sujets en profondeur dans le livre "La prépa physique de l'endurance" .

Les études disent...mais les humains postulent

La première chose à considérer est que derrière le célèbre “les études disent” et les bases de données, il y a des êtres humains qui, souvent passionnés, font du mieux possible pour traiter les sujets dont ils se sont emparés. Cela signifie aussi qu’ils font des erreurs, que certains sont très compétents, d’autres moins, et que, malgré toute la rigueur scientifique du monde, celle-ci ne concerne que la méthodologie, pas la pertinence de la recherche dans le contexte qui peut intéresser l’entraîneur ou l’athlète. Cela signifie surtout qu’il faut respecter les humains qui sont derrière les “papiers” que nous lisons, en gardant l’esprit critique.

Sans cette analyse critique des travaux scientifiques et la mise au regard de l’expérience de terrain, la science serait une entité sans âme, implacable et omnisciente. Gaston Bachelard, philosophe des sciences l’a parfaitement résumé il y a 80 ans : “Le fait scientifique est conquis, construit, constaté” [1]. En fait, cette conquête démarre d’un postulat ou une idée d’une ou plusieurs personnes, qui seront forcément influencées par leurs représentations (sans que cela ne soit problématique). Suite à cela, la connaissance scientifique permet d’envisager les manières de tester, et la méthode scientifique de constater les faits du mieux possible.

Pour résumer, des chercheurs vont se dire : “Je pense que x peut influer sur y”, ou “Que se passe-t-il si je mets en place A dans le contexte B”, ou même “Cette méthode a l’air de donner de bons résultats sur le terrain, je vais essayer de comprendre pourquoi”, puis vont tester ce qui se passe. Les entraîneurs et athlètes font sensiblement la même chose au quotidien. Ce sont simplement les enjeux et la manière de procéder qui peuvent différer.

C’est-à-dire qu’il n’y a pas de hiérarchie de compétence à envisager (dans un sens, comme dans l’autre) : chacun met en place les solutions qui lui semblent pertinentes par rapport à ce qu’il recherche. Chacun est libre d’utiliser, ou pas, ce que l’autre a expérimenté pour nourrir ses réflexions. Il n‘y a pas de petit père des peuple s de l’entraînement qui aurait à imposer une manière de procéder.

Préparer un marathon = sauver une vie ?

Si dans le domaine de la médecine ou de la rééducation, il est tout à fait logique qu’une approche basée sur les preuves soit prioritaire, rappelons que dans la recherche de la performance, ou du plaisir, le contexte et les enjeux ne sont pas les mêmes. Loin de moi l’idée de vous conseiller de faire fi des recherches scientifiques, je les consulte moi-même régulièrement. Elles ont un énorme avantage : celui de nous donner des pistes de réflexion, tout en ayant la limite d’être imparfaites puisqu’elles dépendent à un moment ou à un autre des perceptions des auteurs.

Je pense qu’on ne pourra jamais construire un entraînement efficace en étant guidé principalement par la recherche scientifique, ce serait commettre une erreur de débutant(e) : celle d’oublier à la fois la spécificité de notre contexte et que le postulat de base est toujours émis par des humains, avec leurs propres limites. Mais se passer des perspectives qu’elle nous offre en serait une autre…

L’être humain est au cœur du sujet : le scientifique, l’entraîneur et le sportif. Le fait que j’aie commencé par rapporter ce qu’a écrit Gaston Bachelard n’est pas anodin, car j’ai la conviction qu’avant de taper le sujet qui nous intéresse dans Pubmed, nous devrions tous commencer par nous intéresser à des disciplines telles que la sociologie.

Cela nous offre une grille de lecture des études sans commune mesure, comme celle que nous propose Georges Balandier dans l’excellent ouvrage Le Désordre, éloge du mouvement [2] :

“S’il est exact que les hommes ont demandé à la science d’apporter sa contribution à un discours de l’ordre qui les rassure, elle n’accomplit plus cette fonction ; elle est d’abord un instrument : son efficacité manipulatrice confirme sa rectitude (…) Mais elle ne pratique plus le discours de l’unité”.

Eurêka, tout est lié !

Afin d’affiner votre grille de lecture des études, je vous invite à envisager ces quelques conseils :

“Il faut comprendre pour mesurer, et non mesurer pour comprendre”.*

Corrélation n’est pas causalité.**

L’absence de preuve n’est pas la preuve d’absence.

* Toujours de Gaston Bachelard

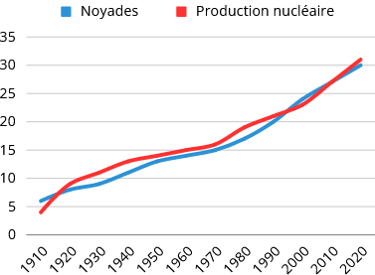

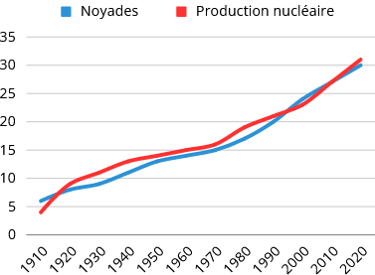

** C’est l‘un des piliers de la zététique (discipline de l‘art du doute). On peut trouver des corrélations pour tout et n‘importe quoi, sans qu‘il n‘y ait de lien de causalité.

On peut par exemple trouver une corrélation entre le nombre de noyades et la production nucléaire. Sans qu’il n’y ait de rapport, ou alors il faut le chercher très loin… Pourtant les courbes sont très jolies non ?

Cet exemple pourrait prêter à sourire, mais lorsqu’une étude publiée dans la très sérieuse revue Nature a conclu qu’il y avait cinq fois plus d’enfants myopes parmi ceux qui dormaient avec la lumière de la pièce allumée que parmi ceux qui dormaient dans l’obscurité [3], la conclusion a donc été, logiquement de prime abord, qu’il fallait arrêter d’utiliser des veilleuses. Mais les auteurs avaient oublié un élément dans l’équation : il existe un lien fort entre la myopie des parents et celles des enfants… parents myopes qui ont tendance à dormir avec la lumière allumée, comme une autre équipe l’a relevé peu de temps après [4].

Ce qui nous intéresse n’est pas de savoir si l’on doit dormir avec une veilleuse ou non, plutôt ce qu’on appelle “l’effet cigogne”. C’est une erreur de raisonnement, qui nous fait déduire que si A et B évoluent de manière similaire, alors A est nécessairement la cause de B. On parle d’effet cigogne, car, puisqu’il y a plus de bébés là où l’on trouve des nids, ce sont les cigognes qui apportent les bébés (alors que le taux de natalité est plus important à la campagne…de même que les cigognes !).

Pour conclure, les scientifiques ne sont pour rien dans l’interprétation que l’on peut faire des résultats de leurs publications : ils proposent et c’est aux personnes concernées sur le terrain de disposer. Ce qui signifie (outre le taux de fiabilité d’une étude) que les débats parfois malsains n’ont pas forcément lieu d’être, du moment où l’on a la compétence et le recul nécessaires pour tirer profit des conclusions des études.

Ils ne sont pas non plus responsables d’une tendance actuelle, qui est au cherry picking, c’est-à-dire de présenter uniquement des données (ou de sélectionner des études) qui donnent du crédit à notre opinion, en occultant celles qui nous contredisent. Si demain, je souhaitais “prouver” une méthode d’entraînement, je trouverais forcément des études (ou bribes d’études) qui vont dans mon sens. Ou, parfois en toute bonne foi, j’aurais tendance à aller chercher les sources qui corroborent mes propos (ce que l’on appelle un biais de confirmation). C’est pour cela que l’argument “prouvé par la science” ne veut, à mon sens, strictement rien dire en matière d’entraînement sportif.

Approche EBP et niveau de preuve

L’EBP (approche basée sur la preuve, sur les données probantes) est de plus en plus mise en avant dans les justifications de contenus d’entraînement.

A l’origine, nous trouvons, l’EBM (M pour Medicine), un paradigme développé dans les années 90 [5], [6] à destination des médecins. En effet, le constat était que la médecine factuelle minimisait l’apport de l’intuition, l’expérience clinique et la justification physiopathologique dans la prise de décision clinique : l’idée était de développer une méthodologie qui “réconcilie” les approches.

Ce paradigme a été ensuite repris dans de nombreuses disciplines, souvent en lien avec la santé, pour arriver au concept d’EBP, qui repose sur 3 piliers [7] :

Les données probantes issues de la recherche scientifique.

L’expertise clinique du praticien.

Les caractéristiques du patient.

Pour résumer, chacun des 3 piliers ne se suffit pas à lui-même pour prendre une décision clinique juste. Cela fait évidemment sens !

Le niveau de preuve

Pour obtenir des données probantes, il est nécessaire d’avoir un niveau de preuve le plus élevé possible : on ne peut évidemment pas opérer toute la population mondiale d’une pathologie en se basant sur la méthode employée en urgence par un boucher moldave qui n’avait pas le choix, même si cela a réussi.

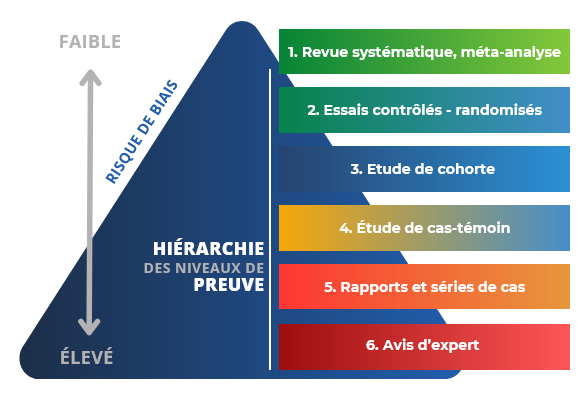

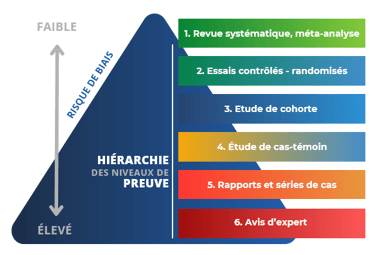

De ce constat (enfin, je ne suis pas persuadé qu’ils aient utilisé mon exemple), est apparue la hiérarchisation du niveau de preuve, qui se lit de haut en bas : en haut, le faible risque (les revues systématiques ou méta-analyses), et en bas le risque de biais très important (comme les avis d’experts).

En fait, cette hiérarchie de preuves a pour but de limiter le risque d’erreur, en prenant en compte le fait que derrière les études, il y a …des êtres humains

Si on a l’avis d’une seule personne, ou les résultats d’un seul cas, le risque de biais est très élevé, et très concentré. Tandis que si on regroupe plusieurs études, idéalement réalisées avec des essais contrôlés — randomisés (considéré comme le gold standard), le risque de biais est beaucoup plus faible, puisque l’erreur est lissée.

En résumé, dans l’entraînement, plus le niveau de preuve d’une publication est élevé, plus on peut le considérer comme fiable pour nous aider à prendre une décision en prenant en compte les caractéristiques du sportif. Sauf que…

La grosse limite de l'approche EBP / EBM dans l'entraînement

Si vous me considérez comme un expert, je suis tout en bas de la pyramide : mon avis ne vaut pas tripette dans la hiérarchie de preuves. Jusque-là, rien de très offensant, c’est somme toute logique…

Le système EBM / EBP est donc probablement un système efficace dans le cadre de la prise de décision clinique (je ne vais pas me lancer dans une analyse de la médecine moderne, je n’en ai pas la compétence, et ce serait sûrement soumis à controverse, à juste titre).

Mais je voudrais souligner que ce paradigme issu de la médecine n’est pas applicable, en l’état, dans le domaine de l’entrainement, il occulte (par la force des choses) un point fondamental : le niveau de pertinence.

Imaginons (au hasard), que j’entraîne des skieurs, et qu’une étude paraisse sur les 4 années d’entraînement d’un champion olympique [11]. Le niveau de preuve serait faible, puisque c’est une étude de cas.

Imaginons ensuite que je prenne mon téléphone pour échanger avec un confrère sur une problématique que je rencontre à propos du renforcement musculaire chez une skieuse de fond. Le niveau de preuve de ce qu’il m’avance serait encore plus faible, puisque c’est un avis d’expert.

Pourtant, dans les deux cas, le niveau de pertinence, pour mon contexte, est extrêmement élevé. Plus qu’une méta-analyse (à niveau de preuve élevé) portant sur la population générale.

Le niveau de pertinence dépend donc du contexte (une méta-analyse peut être très pertinente si je dois tracer les grandes lignes de l‘entraînement de sportifs récréatifs). C‘est à l‘entraîneur, ou au sportif / à la sportive de prendre le recul nécessaire.

D‘ailleurs, sans le formaliser, la majorité pratique déjà une forme d‘EBP, en se renseignant, en faisant appel à sa propre expertise et en prenant en compte les spécificités de chacun, sans pour autant appliquer le modèle tel quel.

Le modèle EBP constitue donc un très bon outil pour nous orienter dans nos lectures et nous aider à prendre du recul sur les conclusions qui y sont présentées. Toutefois, il constitue pas, selon moi, un modèle sur lequel on pourrait se baser à 100% pour entraîner. Pire, en s’y référant strictement, on peut passer à côté de l’essentiel…

1] Bachelard G. (1934). Le nouvel esprit scientifique. PUF.

[2] Balandier G. (1988). Le Désordre, éloge du mouvement. Fayard.

[3] Zadnik, K., Jones, L., Irvin, B. et al. Myopia and ambient night-time lighting. Nature 404, 143–144 (2000). https://doi.org/10.1038/35004661

[4] Night lights not linked to nearsightedness in later childhood. J Natl Med Assoc. 2000 Apr;92(4):A15. PMID: 10976170; PMCID: PMC2640600.

[5] Guyatt G, Cairns J, Churchill D, et al. Evidence-Based Medicine: A New Approach to Teaching the Practice of Medicine. JAMA. 1992;268(17):2420–2425. doi:10.1001/jama.1992.03490170092032

[7] Sackett D L, Rosenberg W M C, Gray J A M, Haynes R B, Richardson W S. Evidence based medicine: what it is and what it isn’t. BMJ 1996; 312 :71 doi:10.1136/bmj.312.7023.71

[7] Luckmann R. Evidence-Based Medicine: How to Practice and Teach EBM, 2nd Edition: By David L. Sackett, Sharon E. Straus, W. Scott Richardson, William Rosenberg, and R. Brian Haynes, Churchill Livingstone, 2000. Journal of Intensive Care Medicine. 2001;16(3):155–156. doi:10.1177/088506660101600307